최근에 리뷰한 Multimodal (V+L) Transformer의 작동 원리를 실험으로 증명한 Research.

친구와 스터디 중에 오랫동안 토론할 만큼 Paper의 Wording(?) 혹은 실험 구성이 애매한 듯하면서도, 개인적으로 흥미로웠던 연구.

(UC Berkeley, 2021) Pretrained Transformers as Universal Computation Engines

논문의 핵심 아이디어는

(자연어 등) 특정 Modality로 Pre-Trained된 Transformer 혹은 순수한 Self-Attention 연산은 다양한 Modality의 Sequential Data가 갖는 Semantic 패턴(Alignment)을 파악할 수 있다

는 점이다.

•

자연어로 Pre-Trained된 Transformer는 다른 Modality로의 Generalization 능력이 충분함

•

이는 Self-Attention이 임의의 Data Sequence가 갖는 Semantic 패턴을 Capture할 수 있기 때문

•

증명을 위해 Pre-Trained Transformer (GPT-2)의 Self-Attention & Feedforward Layer를 고정하고, 나머지 극소수 Params만을 Update하는 Frozen Pre-Trained Transformer (FPT) 제안

•

Numerical Computation (Bit 연산), Image Classification, Protein Fold Prediction Tasks에 FPT를 적용하여 다른 Modality에서 성능 측정

실험의 종류는 다양한데, 대부분 당연한 느낌의 결과들을 보임.

개인적으로 의미있는 결과들을 정리하면,

1.

모든 Tasks에서 FPT는 Fully Fine-Tuned Transformer에 준하는 혹은 그 이상의 성능을 보임

a.

Pre-Training과 Downstream Task의 Modality가 일치하지 않아도 Self-Attention이 잘 동작함

2.

Self-Attention Params가 Random하게 설정된 FPT (Random-FPT)도 성능이 크게 떨어지지 않음

a.

논문의 Killing Point라고 생각하는데, 애초에 Self-Attention은 Layer의 Params가 아닌 연산 자체로서 의미가 있음을 생각할 수 있음

b.

실제로 Random-FPT의 구조를 LSTM으로 교체하면 심각한 성능 저하가 발생함

c.

Random-FPT는 일반적인 FPT에 비해 학습 수렴 속도가 느림

3.

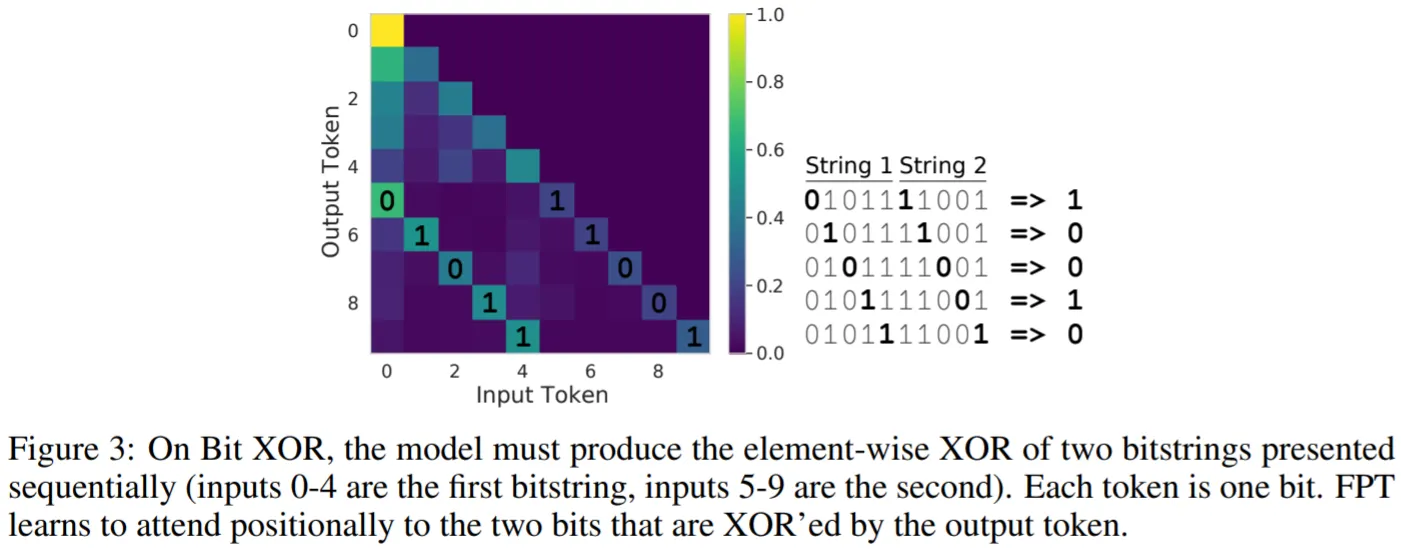

FPT는 XOR Bit 연산과 같이 자연어에서 일반적이지 않은 Semantic 패턴도 파악할 수 있음(그림)

a.

Self-Attention은 순수하게 Sequence의 패턴을 파악하는 역할만을 수행하고,

b.

Input & Output & Layer Norm 등의 Layers가 Domain & Task-Specific한 정보를 담는 것으로 이해함 (애매하지만, Attention is Not All You Need와 같은 느낌으로 논문을 리뷰함)