친구와 논문 리뷰를 하다가 찾게된 연구들.

낯선 분야에 수식도 많아 힘들어 하던 중에 좋은 한국어 강의 (세미나) Youtube를 찾아 열심히 청강함!

Sequential (Time Series) Inputs에 특화된 RNN이지만, 정작 Hidden States는 Discrete한 점을 지적 및 보완하는 LTC와,

이를 기반으로 적은 수의 뉴런으로 자율 주행 (Good Generalization)을 수행하는 NCP.

Large Scaling을 통한 성능 향상이 공식처럼 되어버린 자연어처리와 다른 느낌의, 진짜 연구같은 연구.

Neural Net과 Generalization에 관한 색다른 관점을 갖게 해준 계기가 되었음.

LTC: https://arxiv.org/abs/2006.04439

NCP: https://www.nature.com/articles/s42256-020-00237-3

Youtube: https://www.youtube.com/watch?v=JyMVVlsKpv4

Workshop PDF:

https://simons.berkeley.edu/sites/default/files/docs/17404/raminhasanitfcssynthesisslides.pdf

Liquid Time-constant Networks

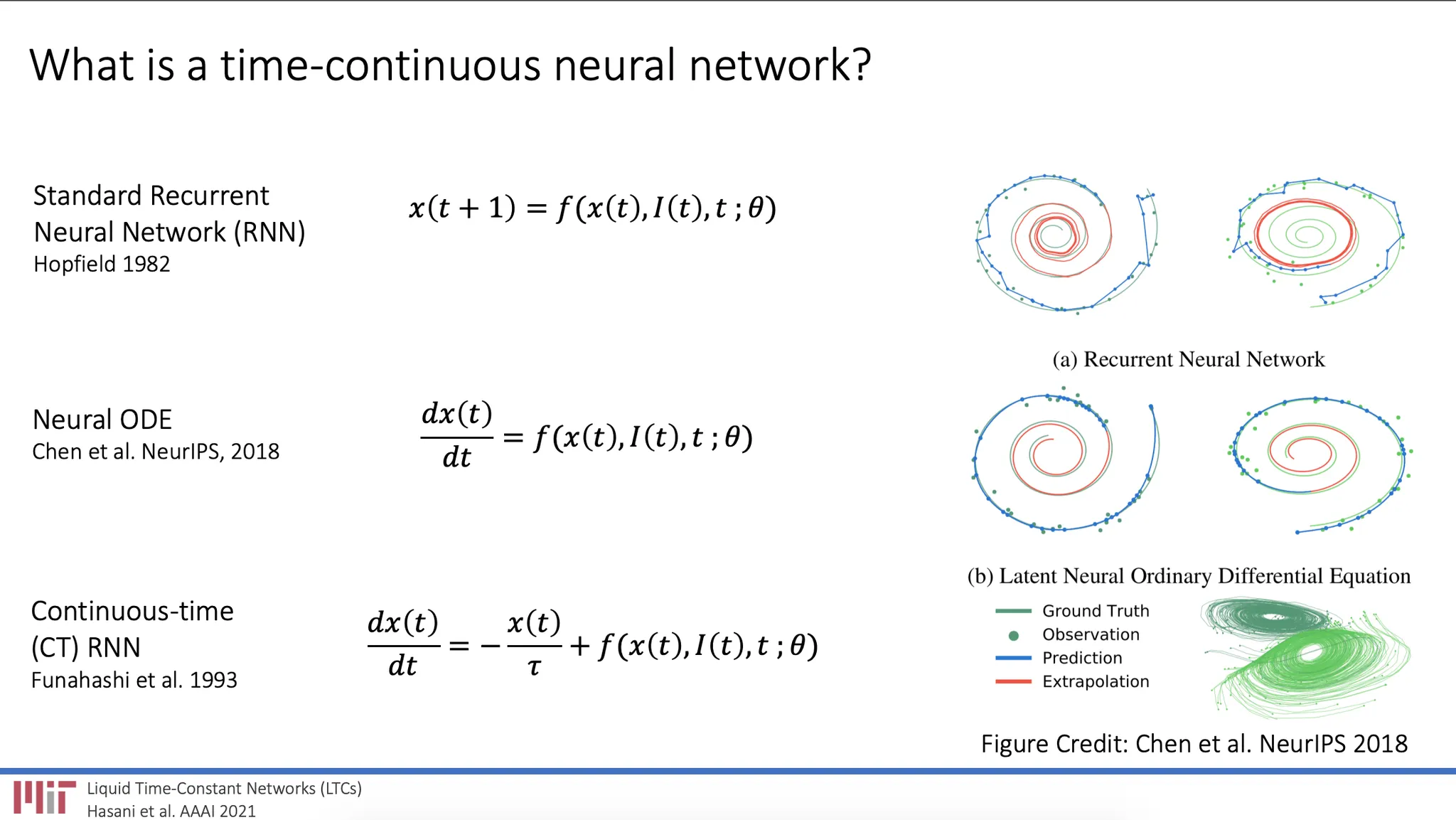

기존의 RNN은 Previous Hidden State: x(t-1), Input: I(t)으로부터 Current Hidden State: x(t)를 계산하는 Function으로 Neural Network: f를 활용하고 (Parameters: ), Back Prop을 통해 를 Update함.

RNN의 Discrete Hidden States는 Sequential (Time Series) Data를 표현하는 데 한계가 있음.

문제가 되는 예시로, 유저의 쇼핑 기록을 통해 새로운 상품을 추천하는 Rec Sys가 있다고 가정. 유저의 쇼핑 기록은 Discrete하지만 (1월 18일, 1월 22일..), 실제 유저가 사고 싶어하는 상품은 매일, 매순간 변화하고 있음. 이와 같이 실생활, 자연 현상들의 Continuous함을 담기에 RNN의 방식은 한계가 있음.

Neural ODE는 이를 해결하기 위해 특정 Time Step: t에서 Hidden State: x(t)의 미분 값을 표현하는 데에 Neural Network: f를 활용함.

(Neural ODE를 Back Prop하는 과정이 까다로운데, 이를 ODE Solver로 풀어나가는 방법은 복잡하고, 완벽한 이해가 되지 않았기에 생략함  )

)

LTC 역시 Neural ODE의 한 종류로, CT-RNN의 변형 Form으로 생각할 수 있음.

Neural circuit policies enabling auditable autonomy

NCP는 대략 300개의 뉴런만으로 구성된 C. Elegans라는 생물에 영감을 받아, 19개의 Control 뉴런들로 자율 주행 (핸들링)을 구현한 연구로, NCP의 정확한 의미는 뉴런들을 서로 연결하는 방법론 (Policy)을 뜻함.

LTC와 동일한 저자들의 연구로, NCP의 기본 모델로 LTC를 적용함.

좋은 Generalization 능력을 보이는데 그 이유가 NCP에서 비롯된 것인지, 혹은 LTC의 성능에 의한 것인지 명확하지 않음.

Input 이미지를 CNN에 태우기 때문에 Parameter 수가 극단적으로 작지 (0에 가깝지)는 않음.